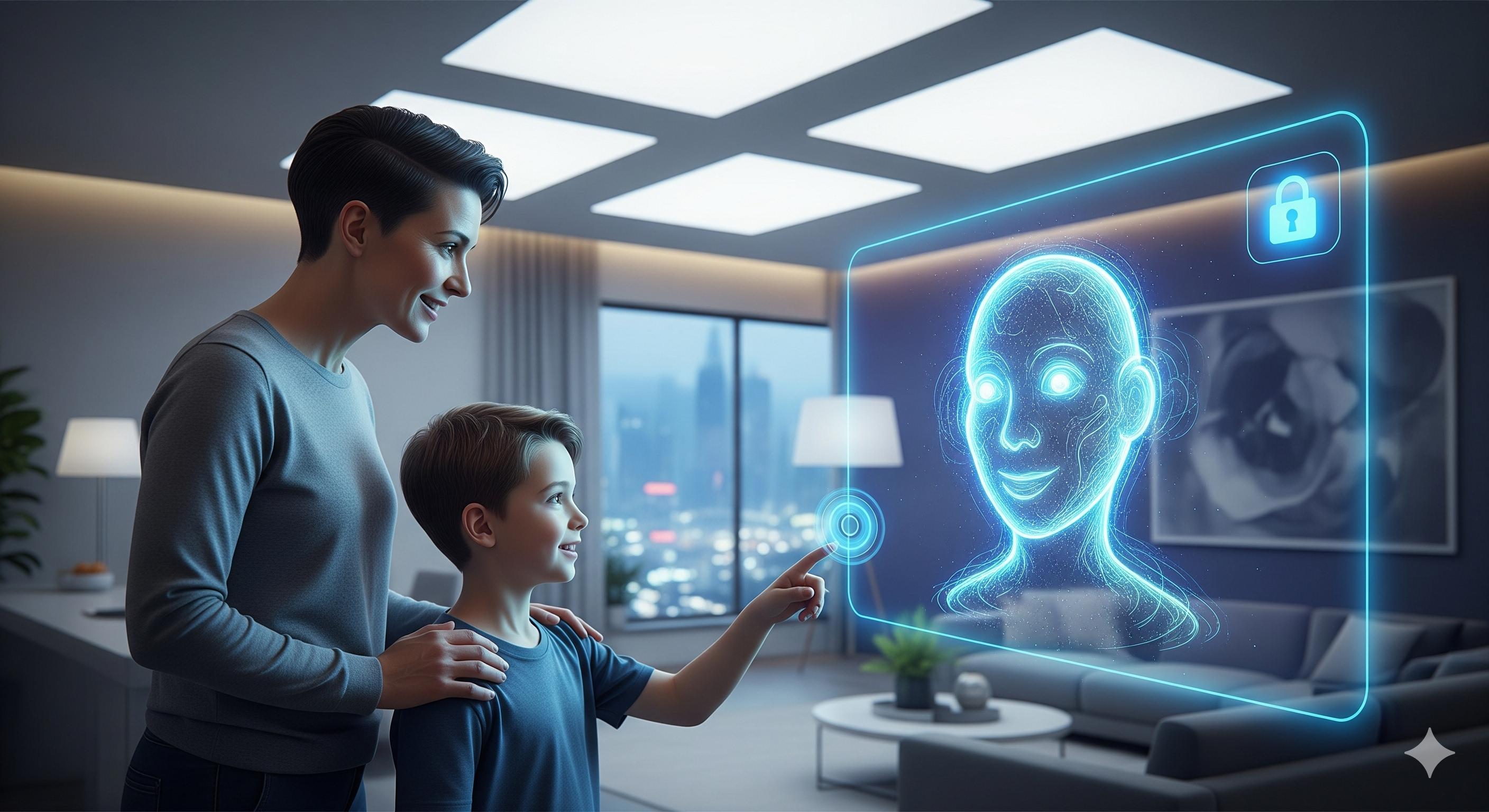

Ahora, OpenAI, consciente de esta creciente preocupación, parece estar dando un paso adelante con una novedad que, de confirmarse, marcará un antes y un después en la gestión de contenidos: la implementación de un "control parental" en GPT-5.

Esta noticia, que aún se mueve en el terreno de los rumores y las funciones experimentales, refleja una tendencia ineludible: la necesidad de una IA más responsable y adaptada a la diversidad de sus usuarios.

¿Qué implica el 'Control parental' en GPT-5?

Aunque los detalles son escasos y aún no hay confirmación oficial de OpenAI, las filtraciones y los análisis de expertos apuntan a una serie de funcionalidades que permitirían una mayor supervisión y filtrado de contenidos cuando la IA es utilizada por menores:

Restricción de contenido sensible: El objetivo principal es evitar que los usuarios menores de edad accedan a información inapropiada, violenta, sexualmente explícita o que promueva conductas perjudiciales. Esto se alinea con la creciente preocupación por la exposición de niños y adolescentes a contenidos no aptos en internet. [GPT Zone]

Filtrado por edad: Se especula con la posibilidad de establecer perfiles de usuario basados en la edad, ajustando el tipo y la complejidad de las respuestas de la IA. Esto permitiría a GPT-5 adaptar su discurso, evitar temas complejos o sensibles y ofrecer explicaciones más sencillas y adecuadas a la etapa de desarrollo cognitivo del menor.

Supervisión y reporte: Es probable que se incluyan herramientas para que padres o tutores puedan supervisar las interacciones del menor con la IA, e incluso reportar contenido problemático. Esto transformaría a la IA en una herramienta educativa y de apoyo, en lugar de un riesgo potencial.

El debate abierto: Seguridad vs. libertad y el rol del regulador

La llegada de estas funciones, aunque bienvenida por muchos, no está exenta de debate. Por un lado, la seguridad y protección de los menores es una prioridad innegociable. Organismos como la Agencia Española de Protección de Datos (AEPD) ya han alertado sobre los desafíos de la IA en relación con los derechos de los niños, especialmente en lo que respecta a la privacidad y el contenido generativo.

Por otro lado, surge la discusión sobre los límites del filtrado y la posible censura de información. ¿Quién decide qué es "apropiado" y hasta qué punto se debe restringir el acceso a ciertos temas, incluso con buenas intenciones? Como señala un reciente análisis de El País sobre la ética en la IA, "la delgada línea entre la protección y la limitación del acceso al conocimiento es uno de los mayores dilemas de la inteligencia artificial".

Para los despachos de abogados y asesores, este tema es de vital importancia. No solo por el aspecto de la protección de datos de menores (regulado por normativas como el RGPD), sino también por las posibles implicaciones legales en cuanto a la responsabilidad de las plataformas de IA por el contenido generado y consumido por usuarios vulnerables. La creación de un marco normativo claro, como el que se está desarrollando con la Ley de Inteligencia Artificial de la UE, será fundamental para equilibrar estos intereses.

Un paso hacia una IA más contextual y humana

La implementación de un control parental en GPT-5, más allá de la protección, denota una evolución en el diseño de la IA: una IA que no solo "sabe" responder, sino que también "entiende" el contexto de su usuario y sus posibles vulnerabilidades. Es un paso hacia una inteligencia artificial más empática y con una mayor conciencia de su impacto social.

En el Centro de Innovación, siempre hemos defendido que la tecnología debe ser una herramienta al servicio de las personas, y no al revés. Esta novedad en GPT-5 es un reflejo de esa filosofía y nos invita a reflexionar sobre cómo podemos integrar la IA de manera segura y ética en todos los ámbitos, incluyendo la educación y la protección de los más jóvenes